- Se incorporó

- 15 Enero 2004

- Mensajes

- 11.957

Tengo que implementar un servicio que analice logs de aplicaciones y servicios en Linux.

Hasta hace un tiempo, tenía los servidores de base de datos Oracle y Weblogic enganchados a una suite propia de Oracle para monitoreo (Oracle Cloud Control). Era la cumbia pero llegaron servidores de otros sabores y ahí la solución de Oracle no me sirve sin pagar extra.

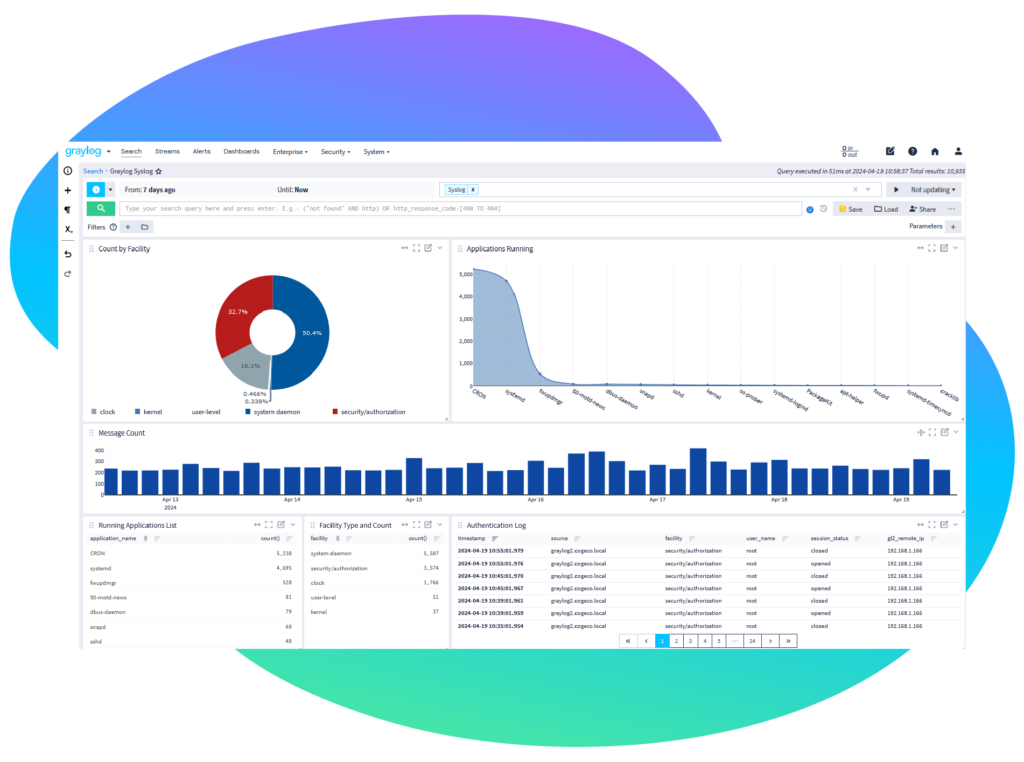

Me puse a cachurear y encontré Graylog. Creo que anda bien y lo voy a revisar pero me gustaría saber si tienen experiencias en otros sistemas analizadores de logs.

www.graylog.org

www.graylog.org

Lo voy a usar para

logs de Oracle (el alert.log)

logs de wildfly (es la rama community de jboss)

logs de Weblogic

y ya que estamos en esta, el messages de linux.

Gracias

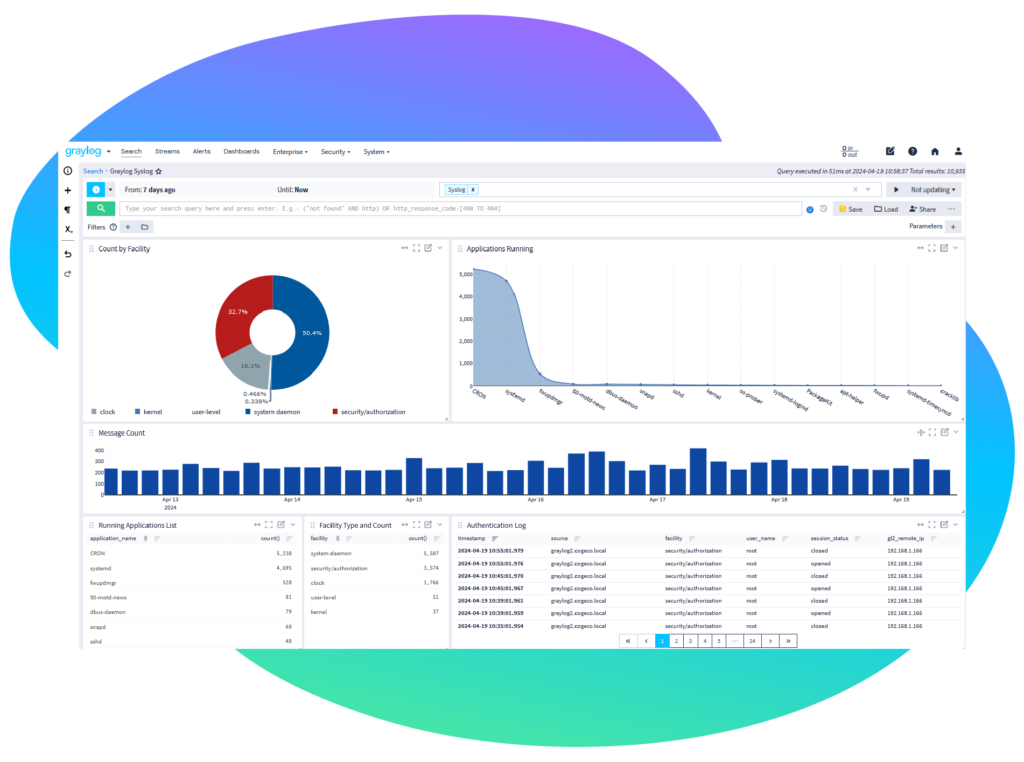

Hasta hace un tiempo, tenía los servidores de base de datos Oracle y Weblogic enganchados a una suite propia de Oracle para monitoreo (Oracle Cloud Control). Era la cumbia pero llegaron servidores de otros sabores y ahí la solución de Oracle no me sirve sin pagar extra.

Me puse a cachurear y encontré Graylog. Creo que anda bien y lo voy a revisar pero me gustaría saber si tienen experiencias en otros sistemas analizadores de logs.

Centralized Log Management | Advanced Features & Tools

Explore Graylog Open for centralized log management with custom dashboards, advanced search, and robust fault tolerance. Get started now!

Lo voy a usar para

logs de Oracle (el alert.log)

logs de wildfly (es la rama community de jboss)

logs de Weblogic

y ya que estamos en esta, el messages de linux.

Gracias